Als Agentur arbeiten wir täglich daran, die Performance von Social-Media-Kampagnen zu verbessern. Es gibt jedoch kein allgemeingültiges Erfolgsrezept und was für eine Marke perfekt funktioniert, kann bei einer anderen ins Leere laufen. Deshalb verlassen wir uns nicht auf unser Bauchgefühl oder Trends, sondern auf gezielte Experimente.

Durch A/B Tests konnten wir bereits bei vielen Kundinnen und Kunden wichtige Metriken wie Klickrate, Engagement oder Conversion Rate deutlich steigern. Oft führen schon kleine Anpassungen zu messbaren Verbesserungen.

In diesem Beitrag zeigen wir dir, wie A/B Testing funktioniert, worauf du achten musst und wie du deine eigenen Social-Media-Tests optimal aufsetzt. Am Schluss findest du ausserdem eine praktische Checkliste zum Download.

Was ist A/B Testing?

Beim A/B Testing vergleichst du zwei Versionen eines Inhalts, um herauszufinden, welche besser funktioniert. Dabei änderst du jeweils nur eine einzelne Variable, zum Beispiel:

- Die Ad Copy

- Das Bild

- Das Targeting

Warum sich A/B Testing für dich lohnt

- Du lernst deine Zielgruppe besser kennen

Durch regelmässiges Testen findest du heraus, welche Inhalte am besten ankommen. - Du triffst fundierte Entscheidungen

Anstatt auf Vermutungen zu setzen, stützt du dich auf klare Daten. - Du verbesserst deine Ergebnisse

Mit jedem Test optimierst du weiter und holst mehr aus deinen Inhalten heraus.

Was bedeutet statistische Signifikanz?

Ein Testergebnis ist nur dann aussagekräftig, wenn es statistisch signifikant ist. Das heisst, der Unterschied zwischen den beiden Varianten ist nicht zufällig, sondern basiert auf echten Effekten.

In der Praxis bedeutet das:

- Du brauchst eine ausreichend grosse Testgruppe

- Der Test muss lange genug laufen

- Der sogenannte p-Wert sollte unter 0.05 liegen

Nützliche Tools für die Berechnung:

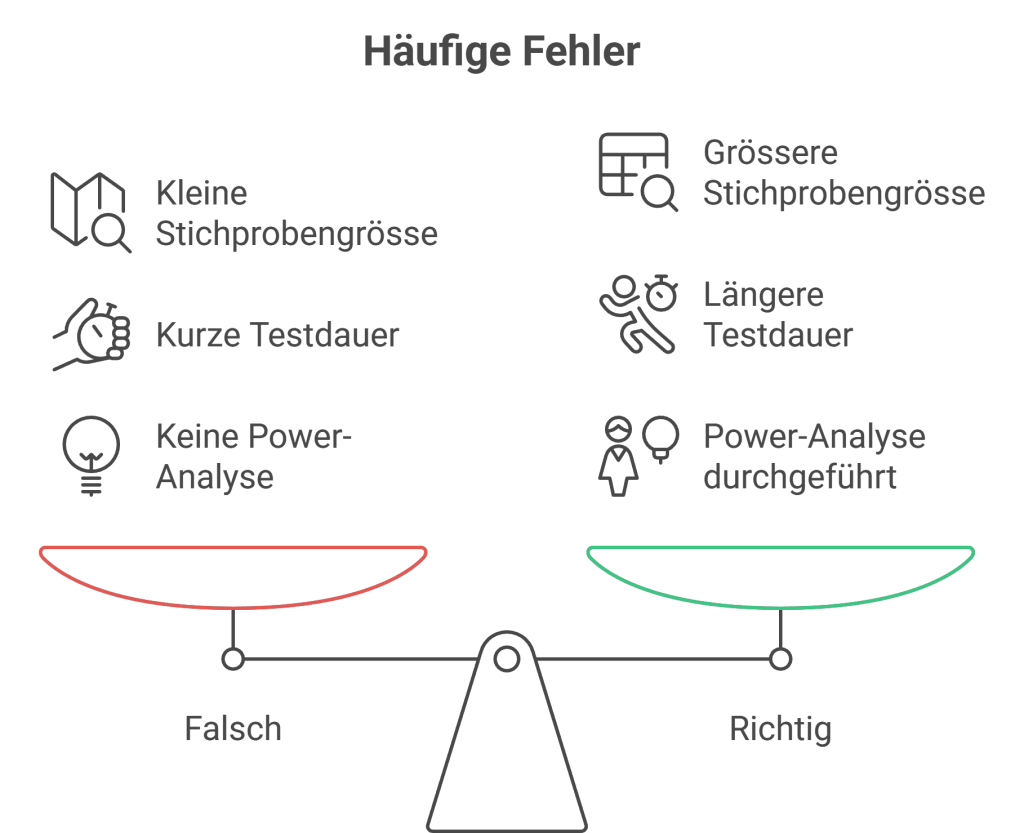

Was passiert, wenn du die Signifikanz nicht beachtest?

Ein bekanntes Beispiel kommt vom Bing-Team von Microsoft. Dort wurde die Farbe der Links in den Suchergebnissen leicht angepasst, um die Klickrate zu erhöhen.

Im ersten Test zeigte sich kein Unterschied. Die erste Schlussfolgerung: Es bringt nichts. Also blieb alles beim Alten.

Später zeigte sich jedoch:

- Die Testgruppe war zu klein

- Der Test lief nicht lange genug

- Es wurde keine Power-Analyse gemacht

Ein erneuter, grösser angelegter Test zeigte schliesslich: Die neue Farbe führte zu einem signifikanten Anstieg der Klickrate und sorgte für Millionen an zusätzlichem Umsatz pro Jahr.

Falls du noch mehr dazu erfahren möchtest, wie stark Farben und Kontraste tatsächlich auf Conversions und Klickverhalten wirken können, empfehlen wir den Blog-Beitrag von Erin Weigel. Hier geht’s zum Artikel: How Microsoft made big conversion gains with small color tweaks

Fazit: Ohne Signifikanzprüfung kannst du wichtige Erkenntnisse verpassen und falsche Entscheidungen treffen.

Häufige Fehler

Damit dein Test aussagekräftig ist, solltest du diese Punkte beachten:

- Nur eine Variable testen – Veränderst du mehrere Dinge gleichzeitig, weisst du nicht, welche davon den Ausschlag gab

- Gleich grosse Testgruppen & Budgets – Die beiden Varianten müssen unter denselben Bedingungen ausgespielt werden

- Ausreichend lange testen – Mindestens 7-14 Tage. So lassen sich auch Unterschiede über Wochentage oder Tageszeiten erkennen

Fazit

A/B Testing ist ein einfaches, aber wirkungsvolles Mittel, um deine Inhalte zu optimieren. Du triffst bessere Entscheidungen, verstehst deine Zielgruppe besser und erzielst nachhaltigere Ergebnisse.

Wenn du beim Aufsetzen oder Auswerten deiner Tests Unterstützung brauchst, sind wir gerne für dich da. Wir begleiten dich vom ersten Konzept bis zur finalen Analyse.

Deine Checkliste für erfolgreiche A/B Tests

Damit du bei deinem nächsten Test nichts vergisst, haben wir eine kompakte Checkliste für dich erstellt. Von der Zieldefinition über die Umsetzung bis zur Auswertung findest du hier alle wichtigen Punkte.